Cała generacja komputerówużytkowników, którzy nie złapali słynnego „wyścigu megaherców”, jaki toczył się między dwoma czołowymi producentami jednostek centralnych do komputerów stacjonarnych (którzy nie wiedzą - Intel i AMD) na przełomie tysiącleci. Skończył się około 2004 roku, kiedy okazało się, że częstotliwość procesora nie jest jedyną cechą wpływającą na jego wydajność. Ekstremalnie „żarłoczne” i niezwykle wysokoczęstotliwościowe procesory Pentium IV na rdzeniu Prescotta zbliżały się do 4 GHz, a jednocześnie z trudem mogły konkurować z architekturą K8, na której zbudowano nowe „kamienie” AMD, które miały częstotliwość nie wyższa niż 2,6-2,8 GHz.

Potem obaj producenci jednocześnie wyprowadzili się zpraktyki identyfikacji swoich produktów na podstawie częstotliwości pracy i przeniosły się do abstrakcyjnych indeksów modelowych. Decyzja ta była uzasadniona niechęcią do wprowadzenia użytkownika końcowego w błąd co do wydajności procesora, skupiając się tylko na jednej z jego cech. Rzeczywiście, jest też częstotliwość magistrali procesora i rozmiar pamięci podręcznej, a także proces technologiczny, w którym wykonany jest rdzeń, i wiele więcej. Jednak dla większości ludzi częstotliwość procesora jest nadal jednym z najbardziej wizualnych i intuicyjnych mierników „jakości” procesora.

Rzeczywiście, taktowanie procesora jestwpływa na jego wydajność, charakteryzując liczbę operacji wykonywanych na sekundę. Ale faktem jest, że procesory zbudowane na różnych rdzeniach spędzają różną liczbę cykli zegara na jedną operację, a ten parametr może się znacznie różnić w zależności od generacji. To dzięki temu obecny procesor o nominalnej częstotliwości 2,0 GHz pozostawi daleko w tyle za flagowym sprzed siedmiu lat z częstotliwością taktowania 3,8 GHz. Ponadto na szybkość procesora, jak już wspomniano powyżej, wpływa wielkość pamięci podręcznej (im jest ona większa, tym rzadziej procesor będzie zmuszony uzyskać dostęp do stosunkowo wolnej pamięci RAM) oraz częstotliwość magistrali procesora (im wyższa czyli im szybsza wymiana danych pomiędzy „kamieniem” a RAMem) i wiele innych, nie tak zauważalnych, ale nie mniej ważnych cech.

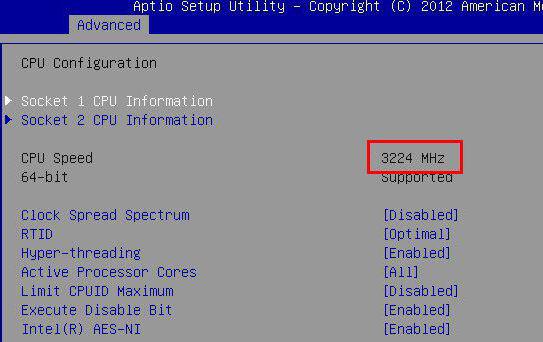

Niedawno zaczęto stosować taką koncepcję, jak maksymalna częstotliwość procesora.

Stopniowo wprowadzają zarówno Intel, jak i AMDprodukty takie jak automatyczne podkręcanie. Technologia jest w zasadzie taka sama, jeden producent nazywa Turbo Boost, inny - Turbo Core, ale nie zmienia to jego istoty: częstotliwość procesora może zmieniać się dynamicznie i automatycznie, bez interwencji użytkownika. Potrzeba wykorzystania tej technologii wynika z faktu, że wielordzeniowość nowoczesnych procesorów stała się de facto normą, ale wielowątkowość współczesnych aplikacji niestety jeszcze nie jest. System operacyjny, widząc, że jeden z rdzeni procesora jest ładowany znacznie mocniej niż inne, niezależnie zwiększa częstotliwość tego rdzenia, próbując pozostawić procesor w swoim „natywnym” pakiecie termicznym (tj. System próbuje się ubezpieczyć przed przegrzaniem sprzętu). Co więcej, w zależności od modelu procesora i od konkretnych warunków, taki wzrost częstotliwości może wynosić od 100 do 600-700 MHz, a to, trzeba się zgodzić, jest znacznym wzrostem wydajności. Większość najnowszych procesorów obu producentów obsługuje tę technologię. Intel ma w szczególności wszystkie procesory z linii Core i5 i Core i7, AMD ma wszystkie procesory na gnieździe AM3 +, procesory na gnieździe FM1 (z wyjątkiem procesorów z wyłączonym rdzeniem graficznym), a także kilka „kamieni” na platformę AM3 (sześciordzeniowy Tuban i czterordzeniowy Zosma). Co więcej, w przypadku procesorów Intela opartych na Socket 1155 takie automatyczne podkręcanie jest tym bardziej istotne, biorąc pod uwagę, że z powodu pewnych cech architektonicznych pełne „przetaktowanie” poprzez zwiększenie częstotliwości magistrali procesora jest praktycznie niemożliwe. To jednak temat na zupełnie inny artykuł ...